elevne's Study Note

딥러닝 파이토치 교과서 (6-4: ResNet(2)) 본문

이제 ResNet 모델을 구성할 차례였다. ResNet 의 전체 네트워크 구성을 위해 이를 구성하는 기본 블록과 병목 블록을 따로 정의한다. 우선 아래와 같이 기본 블록을 작성한다. 이는 ResNet18, ResNet34 에서 사용되며 합성곱 (3x3) 두 개로 구성된다.

class BasicBlock(nn.Module):

expansion = 1

def __init__(self, in_channels, out_channels, stride = 1, downsample = False):

super().__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size = 3,

stride = stride, padding = 1, bias = False)

self.bn1 = nn.BatchNorm2d(out_channels)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size = 3,

stride = 1, padding = 1, bias = False)

self.bn2 = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace = True)

if downsample:

conv = nn.Conv2d(in_channels, out_channels, kernel_size = 1,

stride = stride, bias = False)

bn = nn.BatchNorm2d(out_channels)

downsample = nn.Sequential(conv, bn)

else:

downsample = None

self.downsample = downsample

def forward(self, x):

i = x

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.conv2(x)

x = self.bn2(x)

if self.downsample is not None:

i = self.downsample(i)

x += i

x = self.relu(x)

return x

위 __init__ 함수에서는 downsample 이라는 것이 사용되었다. Downsample 은 입력데이터의 크기와 네트워크를 통과한 후 출력 데이터의 크기가 다를 경우에 사용한다. 또, forward 함수 내에서 x += i 를 해주는 것을 확인할 수 있는데 이는 아이덴티티 매핑이 적용되는 부분인 것이다. 특정 층에 존재하는 출력 결과를 다음 합성곱층을 통과한 출력 결과에 더해주는 것으로 Skip Connection 이라고도 한다.

그 다음으로는 병목블록을 작성했다. 병목블록은 ResNet50, 101, 152 에서 사용되며 1 x 1 합성곱층, 3 x 3 합성곱층, 1 x 1 합성곱층으로 구성된다.

class Bottleneck(nn.Module):

expansion = 4

def __init__(self, in_channels, out_channels, stride = 1, downsample = False):

super().__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size = 1, stride = 1, bias = False)

self.bn1 = nn.BatchNorm2d(out_channels)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size = 3, stride = stride, padding = 1, bias = False)

self.bn2 = nn.BatchNorm2d(out_channels)

self.conv3 = nn.Conv2d(out_channels, self.expansion * out_channels, kernel_size = 1,

stride = 1, bias = False)

self.bn3 = nn.BatchNorm2d(self.expansion * out_channels)

self.relu = nn.ReLU(inplace = True)

if downsample:

conv = nn.Conv2d(in_channels, self.expansion * out_channels, kernel_size = 1,

stride = stride, bias = False)

bn = nn.BatchNorm2d(self.expansion * out_channels)

downsample = nn.Sequential(conv, bn)

else:

downsample = None

self.downsample = downsample

def forward(self, x):

i = x

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.conv2(x)

x = self.bn2(x)

x = self.relu(x)

x = self.conv3(x)

x = self.bn3(x)

if self.downsample is not None:

i = self.downsample(i)

x += i

x = self.relu(x)

return x

병목블록은 기본블록이 3 x 3 합성곱층 두 개를 갖는 것과 달리 3 x 3, 1 x 1, 3 x 3 의 구조를 갖는다. 기본 블록을 병목 블록으로 대체하는 이유는 계층을 더욱 깊게 쌓으면서 계산에 대한 비용을 줄일 수 있기 때문이다. 그리고 계층이 많아진다는 것은 곧 활성화 함수가 기존보다 더 많이 포함된다는 뜻이며 이것은 더 많은 비선형성을 처리할 수 있음을 의미한다. 위에서 사용한 Skip Connection 과 병목블록을 통해 더욱 깊은 네트워크 계층을 가질 수 있는 것이다.

이제 ResNet 모델 Class 를 작성한다.

class ResNet(nn.Module):

def __init__(self, config, output_dim, zero_init_residual=False):

super().__init__()

block, n_blocks, channels = config

self.in_channels = channels[0]

assert len(n_blocks) == len(channels) == 4

self.conv1 = nn.Conv2d(3, self.in_channels, kernel_size = 7, stride = 2, padding = 3, bias = False)

self.bn1 = nn.BatchNorm2d(self.in_channels)

self.relu = nn.ReLU(inplace = True)

self.maxpool = nn.MaxPool2d(kernel_size = 3, stride = 2, padding = 1)

self.layer1 = self.get_resnet_layer(block, n_blocks[0], channels[0])

self.layer2 = self.get_resnet_layer(block, n_blocks[1], channels[1], stride = 2)

self.layer3 = self.get_resnet_layer(block, n_blocks[2], channels[2], stride = 2)

self.layer4 = self.get_resnet_layer(block, n_blocks[3], channels[3], stride = 2)

self.avgpool = nn.AdaptiveAvgPool2d((1,1))

self.fc = nn.Linear(self.in_channels, output_dim)

if zero_init_residual:

for m in self.modules():

if isinstance(m, Bottleneck):

nn.init.constant_(m.bn3.weight, 0)

elif isinstance(m, BasicBlock):

nn.init.constant_(m.bn2.weight, 0)

def get_resnet_layer(self, block, n_blocks, channels, stride = 1):

layers = []

if self.in_channels != block.expansion * channels:

downsample = True

else:

downsample = False

layers.append(block(self.in_channels, channels, stride, downsample))

for i in range(1, n_blocks):

layers.append(block(block.expansion * channels, channels))

self.in_channels = block.expansion * channels

return nn.Sequential(*layers)

def forward(self, x):

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.maxpool(x)

x = self.layer1(x)

x = self.layer2(x)

x = self.layer3(x)

x = self.layer4(x)

x = self.avgpool(x)

h = x.view(x.shape[0], -1)

x = self.fc(h)

return x, h

위 __init__ 함수 내의 if zero_init_residual: 부분은 각 Residual branch 에 있는 마지막 Batch Normalization 을 0 으로 초기화해서 다음 Residual branch 를 0 에서 시작할 수 있도록 하는 것이다. BN 을 0 으로 초기화할 경우 모델 성능이 0.2 ~ 0.3 % 정도 향상될 수 있다고 한다.

위와 같이 작성한 Class 를 사용하기 위해서는 몇 가지 준비가 더 필요하다.

ResNetConfig = namedtuple('ResNetConfig', ['block', 'n_blocks', 'channels'])

resnet18_config = ResNetConfig(block = BasicBlock,

n_blocks = [2,2,2,2],

channels = [64, 128, 256, 512])

resnet34_config = ResNetConfig(block = BasicBlock,

n_blocks = [3,4,6,3],

channels = [64, 128, 256, 512])

resnet50_config = ResNetConfig(block = Bottleneck,

n_blocks = [3, 4, 6, 3],

channels = [64, 128, 256, 512])

resnet101_config = ResNetConfig(block = Bottleneck,

n_blocks = [3, 4, 23, 3],

channels = [64, 128, 256, 512])

resnet152_config = ResNetConfig(block = Bottleneck,

n_blocks = [3, 8, 36, 3],

channels = [64, 128, 256, 512])

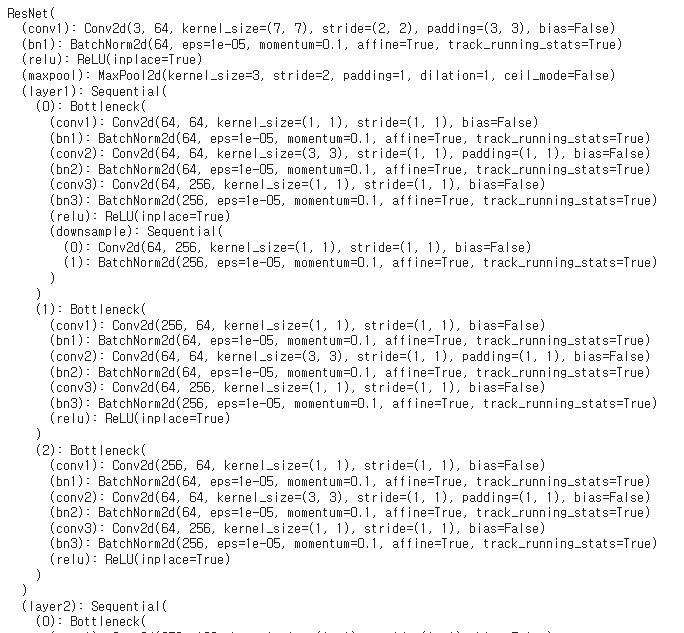

위 Config 들을 사용하여 ResNet 모델을 다양한 방식으로 사용해볼 수 있다. 이번 실습에서는 ResNet50 을 사용해보았다.

OUTPUT_DIM = 2

model = ResNet(resnet50_config, OUTPUT_DIM)

print(model)

모델은 준비되었으니 옵티마이저와 손실함수를 정의한 다음 학습 지표를 계산하는 함수를 작성한다.

optimizer = optim.Adam(model.parameters(), lr=1e-7)

criterion = nn.CrossEntropyLoss()

model = model.to(device)

criterion = criterion.to(device)

def calculate_topk_accuracy(y_pred, y, k = 2):

with torch.no_grad():

batch_size = y.shape[0]

_, top_pred = y_pred.topk(k, 1)

top_pred = top_pred.t()

correct = top_pred.eq(y.view(1, -1).expand_as(top_pred))

correct_1 = correct[:1].reshape(-1).float().sum(0, keepdim = True)

correct_k = correct[:k].reshape(-1).float().sum(0, keepdim = True)

acc_1 = correct_1 / batch_size

acc_k = correct_k / batch_size

return acc_1, acc_k

calculate_topk_accuracy 가 학습이 잘 되었는지 모델 성능 평가를 진행하는 함수이다. 여기서 사용된 tensor.topk 메서드는 torch.argmax() 와 같은 효과이다. 주어진 텐서에서 가장 큰 값의 인덱스를 얻기 위해 사용된다. 그 다음 줄에서 사용된 .t() 메서드는 주어진 텐서의 전치행렬을 반환한다.

이제 모델학습, 평가를 진행하기 위한 코드를 작성한다.

def train(model, iterator, optimizer, criterion, device):

epoch_loss = 0

epoch_acc_1 = 0

epoch_acc_5 = 0

model.train()

for (x, y) in iterator:

x = x.to(device)

y = y.to(device)

optimizer.zero_grad()

y_pred = model(x)

loss = criterion(y_pred[0], y)

acc_1, acc_5 = calculate_topk_accuracy(y_pred[0], y)

loss.backward()

optimizer.step()

epoch_loss += loss.item()

epoch_acc_1 += acc_1.item()

epoch_acc_5 += acc_5.item()

epoch_loss /= len(iterator)

epoch_acc_1 /= len(iterator)

epoch_acc_5 /= len(iterator)

return epoch_loss, epoch_acc_1, epoch_acc_5

def evaluate(model, iterator, criterion, device):

epoch_loss = 0

epoch_acc_1 = 0

epoch_acc_5 = 0

model.eval()

with torch.no_grad():

for (x, y) in iterator:

x = x.to(device)

y = y.to(device)

y_pred = model(x)

loss = criterion(y_pred[0], y)

acc_1, acc_5 = calculate_topk_accuracy(y_pred[0], y)

epoch_loss += loss.item()

epoch_acc_1 += acc_1.item()

epoch_acc_5 += acc_5.item()

epoch_loss /= len(iterator)

epoch_acc_1 /= len(iterator)

epoch_acc_5 /= len(iterator)

return epoch_loss, epoch_acc_1, epoch_acc_5

def epoch_time(start_time, end_time):

elapsed_time = end_time - start_time

elapsed_mins = int(elapsed_time / 60)

elapsed_secs = int(elapsed_time - (elapsed_mins * 60))

return elapsed_mins, elapsed_secs

train 을 위한 준비가 마쳐졌으니 아래 코드를 통해 학습을 진행한다.

best_valid_loss = float('inf')

EPOCHS = 10

for epoch in range(EPOCHS):

start_time = time.monotonic()

train_loss, train_acc_1, train_acc_5 = train(model, train_iterator, optimizer, criterion, device)

valid_loss, valid_acc_1, valid_acc_5 = evaluate(model, valid_iterator, criterion, device)

if valid_loss < best_valid_loss:

best_valid_loss = valid_loss

torch.save(model.state_dict(), '../ResNet-model.pt')

end_time = time.monotonic()

epoch_mins, epoch_secs = epoch_time(start_time, end_time)

print(f'Epoch: {epoch+1:02} | Epoch Time: {epoch_mins}m {epoch_secs}s')

print(f'\tTrain Loss: {train_loss:.3f} | Train Acc @1: {train_acc_1*100:6.2f}% | ' \

f'Train Acc @5: {train_acc_5*100:6.2f}%')

print(f'\tValid Loss: {valid_loss:.3f} | Valid Acc @1: {valid_acc_1*100:6.2f}% | ' \

f'Valid Acc @5: {valid_acc_5*100:6.2f}%')

학습이 잘 진행되는 것을 확인할 수 있다.

Reference:

딥러닝 파이토치 교과서

'Machine Learning > Pytorch' 카테고리의 다른 글

| 딥러닝 파이토치 교과서 (6-6: 이미지분할을 위한 신경망) (0) | 2023.03.31 |

|---|---|

| 딥러닝 파이토치 교과서 (6-5: 객체인식을 위한 신경망) (0) | 2023.03.29 |

| 딥러닝 파이토치 교과서 (6-4: GoogLeNet, ResNet(1)) (0) | 2023.03.22 |

| 딥러닝 파이토치 교과서 (6-3: VGGNet (2)) (0) | 2023.03.21 |

| 딥러닝 파이토치 교과서 (6-3: VGGNet (1)) (0) | 2023.03.20 |